1. Grundlagen der Statistik – Stichprobe vs. Grundgesamtheit

Die klassische Statistik beschäftigt sich unter anderem mit der Grundfrage:

„Wie kann man anhand einer Stichprobe Aussagen über eine Grundgesamtheit treffen?”

Denn eine Vollerhebung ist im industriellen oder gesellschaftlichen Kontext oft nicht möglich. Bei der Verwendung von Erhebungsinstrumenten sehen sich Forscher mit einer Leerstelle konfrontiert, nämlich der Lücke zwischen Stichprobe und Grundgesamtheit. Die Grundgesamtheit bezeichnet die Gesamtheit aller statistischen Einheiten, die in eine Erhebung einbezogen werden. Sie bildet den Kreis aller Einheiten, auf die sich die Erhebung bezieht. Dies können Einwohner eines Staates, Patienten oder Studenten sein, aber auch grundsätzlich alles Mögliche.

Beispiel:

Medizin:

Bei einer Studie zur Erprobung einer medizinischen Behandlung stehen möglicherweise nur 100 Personen zur Verfügung, obwohl diese Behandlung potenziell Millionen Menschen betrifft.

Sozialwissenschaft:

Bei einer Befragung zur Einkommenshöhe in Deutschland können nur 10.000 Menschen befragt werden, obwohl Deutschland ca. 84 Millionen Einwohner hat.

Psychologie:

Bei einem klassischen Experiment zum Abruf aus dem Gedächtnis (basierend auf dem Ebbinghaus-Vergessenskurven-Experiment) wird eine Stichprobe von 50 Studierenden gebeten, eine Liste von Nonsyllaben zu lernen und zu verschiedenen Zeitpunkten wiederzugeben, obwohl diese Erkenntnisse auf alle Menschen mit Kurzzeitgedächtnis übertragbar sein sollen.

Ökonomie:

Bei einer Marktforschungsstudie zur Zahlungsbereitschaft für ein neues Produkt können Unternehmen nur 2.000 potenzielle Kundinnen und Kunden befragen, obwohl der Zielmarkt in Europa mehrere hundert Millionen Menschen umfasst.

Dass mit einer relativ kleinen Stichprobe überhaupt Aussagen über die Grundgesamtheit getroffen werden können, liegt an zwei bedeutenden mathematischen Gesetzmäßigkeiten: dem Gesetz der großen Zahlen (englisch: Law of Large Numbers, kurz: LLN) und dem Zentralen Grenzwertsatz (englisch: Central Limit Theorem, kurz: CLT).

Diese beiden Theoreme sind nicht nur akademisch interessant: Sie sind die mathematische Basis der schließenden Statistik und ermöglichen es uns, mit Konfidenz von einer Stichprobe auf die Population zu schließen.

Die 5 Unterpunkte dieses Kapitels

Um diese Frage vollständig zu beantworten, werden wir die folgenden Themen systematisch durcharbeiten:

Zeigt, wie sich der Stichprobenmittelwert dem wahren Populationsmittelwert annähert, je größer unsere Stichprobe wird. Dies ist das Konvergenz-Prinzip: Mit mehr Daten werden wir präziser. Wir werden das mit realen Simulationen visualisieren.

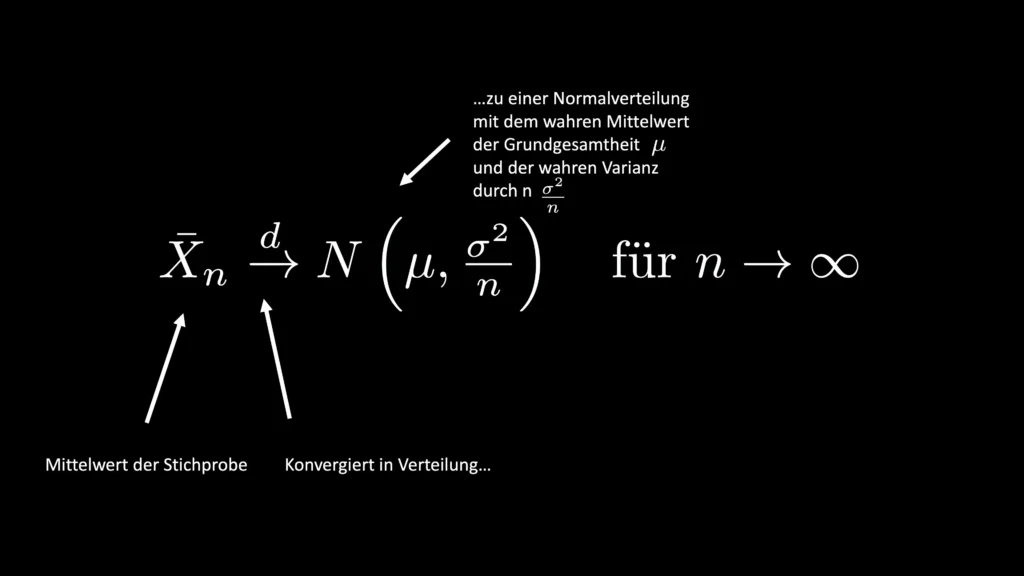

Beantwortet die nächste Frage: Nicht nur dass wir präziser werden—sondern wie präzise? Der CLT erklärt, warum die Mittelwerte von wiederholten Stichproben selbst einer Normalverteilung folgen und wie wir den Standardfehler berechnen können, um unsere Unsicherheit zu quantifizieren.

1.3 Zufallsstichprobe, Zufallsvariable und i.i.d.

Adressiert die kritische Voraussetzung: Beide vorherigen Gesetze funktionieren nur, wenn unsere Stichprobenziehung zufällig ist und die Bedingung „independent and identically distributed“ (i.i.d.) erfüllt ist. Wir zeigen, was passiert, wenn diese Bedingung verletzt wird—und warum Bias und Verzerrung entstehen.

1.4 Zusammenfassung Grundlagen der Statistik

Bringt alle bisherigen Konzepte zusammen: Wie passen LLN, CLT, Zufallsstichprobe und i.i.d. ineinander? Was ist die praktische Konsequenz für einen Forscher?

1.5 Frequentistische Statistik

Ordnet diese Konzepte in ihren philosophischen Kontext ein: Warum denken wir in der klassischen Statistik so? Wie unterscheidet sich der frequentistische Wahrscheinlichkeitsbegriff vom bayesianischen? Und warum sind LLN und CLT die Fundamente dieser Denkweise?

Warum das für Sie wichtig ist

Diese Konzepte sind nicht nur für Forscher wichtig. Sie sind entscheidend für:

Das grundlegende Verständnis der schließenden Statistik: Ohne LLN und CLT sind alle weiteren Vorhaben als Statistiker nicht nachvollziehbar.

Bei der Planung der Erhebung muss man die Voraussetzungen kennen, nämlich die Zufallsauswahl. Andernfalls wird man kein repräsentatives Bild der Grundgesamtheit erhalten.

Interpretation von p-Werten und Konfidenzintervallen: Diese Grundlagen sind gewissermaßen Voraussetzung, um diese zu interpretieren.

Die nächsten Kapitel folgen dieser Logik:

- Zunächst verstehen Sie, wie Stichproben mit der Grundgesamtheit zusammenhängen (LLN)

- Dann lernen Sie, wie präzise diese Beziehung ist (CLT)

- Danach lernen Sie, welche Bedingungen erfüllt sein müssen, damit das funktioniert (i.i.d., Zufallsstichprobe)

- Schließlich integrieren wir alles zu einem Gesamtbild (Zusammenfassung)

- Am Ende verstehen Sie den philosophischen Hintergrund dieser Art zu denken (Frequentismus)

Bereit zum Eintauchen?

Das Schöne an diesem Thema ist: Es ist nicht kompliziert, wenn es gut erklärt wird. Sie werden sehen, dass LLN und CLT elegante, intuitive Konzepte sind—nicht bloß mathematische Abstraktionen.

Klicken Sie auf eines der Kapitel links, um zu beginnen. Jedes Kapitel baut auf dem vorherigen auf, kann aber auch eigenständig gelesen werden.